Cómo Aristóteles Creó El Ordenador

A menudo se cuenta la historia de los ordenadores como una historia de objetos, desde el ábaco hasta la Máquina Diferencial, pasando por las máquinas descodificadoras de la Segunda Guerra Mundial.

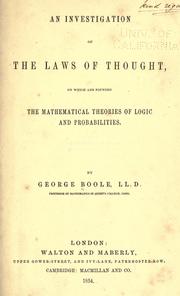

De hecho, se puede entender mejor como una historia sobre las ideas, principalmente ideas que emergieron de la lógica matemática, una disciplina oscura y de culto que se desarrolló por primera vez en el siglo XIX. La lógica matemática se empezó por los filósofos – matemáticos. Los más destacables fueron George Boole y Gottlob Frege quienes, a la vez, estaban inspirados por el sueño de Leibniz de un “lenguaje conceptual” universal y por el antiguo sistema lógico de Aristóteles.

Inicialmente se consideró a la lógica matemática como una materia abstracta, sin esperanza que no tenía aplicaciones concebibles. Como un Ingeniero Informático comenta: “Si, en 1901, se hubiese hecho una encuesta para saber qué ciencia y que rama sería la menos fructífera durante el siglo que se estaba empezando, la elección mayoritaria hubiese sido la lógica matemática“. Cuando lo que pasó realmente, fue que se pusieron sobre la mesa los fundamentos para un campo que tendría mucho más impacto en el mundo moderno que cualquier otro.

La evolución de la informática desde la lógica matemática culminó en los años 1930 con dos papers emblemáticos:

1. “1. A Symbolic Analysis of Switching and Relay Circuits” de Claude Shannon

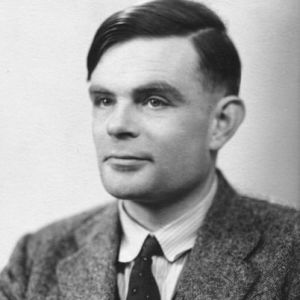

2. “2. On Computable Numbers, With an Application to the Entscheidungsproblem.” de Alan Turing

Shannon y Turing son dos figuras fundamentales en la historia de la informática, eso es obvio, demostrable e irrebatible. Pero lo que solemos obviar es la importancia que los filósofos y lógicos que los precedieron, aportaron a esta ciencia.

Claude Shannon

Alan Turing

Una buena historia de la informática describe el paper de Shannon como “posiblemente la más importante y notoria tesis del siglo“. Shannon lo escribió cuando era estudiante de Ingeniería Eléctrica en el MIT. Su tutor, Vannevar Bush, construyó un prototipo de ordenador llamado el Analizador Diferencial que era capaz de calcular rápidamente ecuaciones diferenciales.

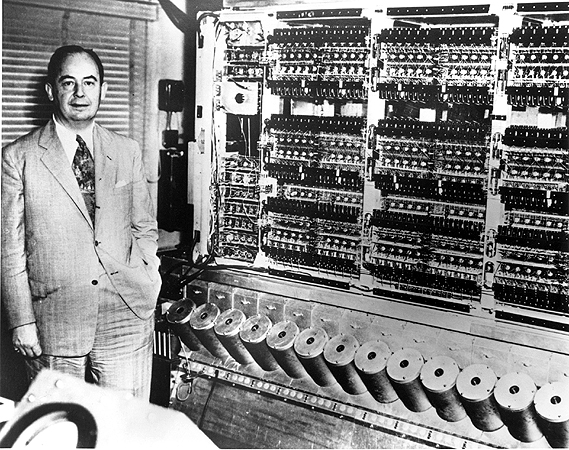

Vannevar Bush y el Analizador Diferencial

El dispositivo era mayormente mecánico, con subsistemas controlados por relés eléctricos, que se organizaban en base a las necesidades del momento ya que no había aún ninguna teoría sobre el diseño de circuitos. De hecho, el tema de la tesis de Shannon nació en el momento en que Bush le recomendó probar de descubrir una teoría como esa.

El paper de Shannon es en muchos modos es el típico paper de Ingeniería Eléctrica, lleno de ecuaciones y de diagramas de circuitos eléctricos. Lo que ya no es tan usual es que la referencia principal fue un trabajo de 90 años atrás sobre filosofía matemática, Las Leyes del Pensamiento de George Boole.

Las Leyes Del Pensamiento, de George Boole

Hoy en día, el nombre de Boole es bien conocido por tod@s l@s Ingenier@s Informátic@s (muchos de los lenguajes de programación tienen un tipo de datos básico -primitivo- llamado Booleano); pero en 1938 raramente se leía su obra fuera de los departamentos de filosofía. El mismo Shannon se encontró con el trabajo de Boole en una clase de filosofía. Más tarde comentó: “Tan sólo ocurrió que nadie era familiar con los dos campos a la vez“.

Normalmente se describe a Boole como matemático, pero él se veía a sí mismo como un filósofo, siguiendo los pasos de Aristóteles. “Las Leyes Del Pensamiento” empieza con una descripción de sus metas, para investigar las leyes fundamentales del funcionamiento de la menta humana:

“El diseño del tratado que sigue es investigar las leyes fundamentales de aquellas operaciones de la mente mediante las cuales se lleva a cabo el razonamiento; darles expresión en el lenguaje simbólico del Cálculo, y establecer la ciencia de la Lógica… y, finalmente, recolectar… algunos de los indicios sobre la naturaleza y la constitución de la mente humana“

Luego rinde tributo a Aristóteles, el inventor de la lógica y la influencia principal de su propio trabajo:

“De un modo antiguo y académico, la materia de la Lógica se debe casi única y exclusivamente a Aristóteles. Se presentó en la antigua Grecia durante las disquisiciones del Organon, en parte técnicas y en parte metafísicas; que han seguido hasta nuestros días“

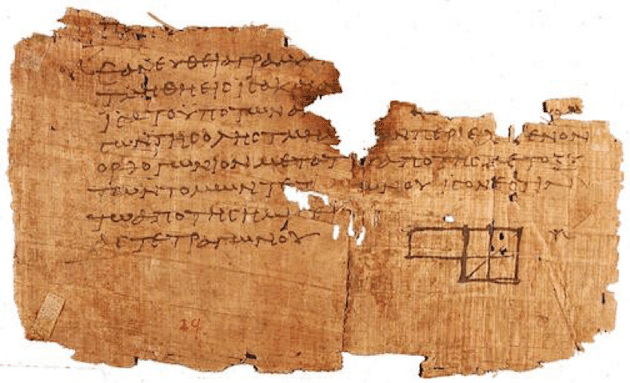

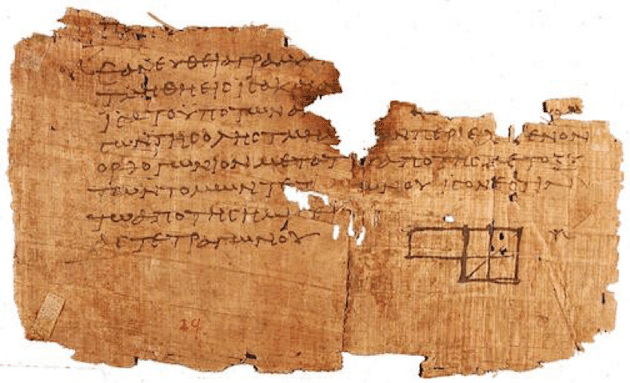

El Organon

Intentar mejorar el trabajo lógico de Aristóteles era un movimiento intelectual temerario. La Lógica Aristotétila se presentó el El Organon, comentó, un libro de 6 partes, que ocupó el centro del canon de la educación durante más de 2000 años. Existía la férrea convicción que todo lo que había escrito Aristóteles era todo lo que se podía decir sobre el tema. El filósofo Immanuel Kant afirmó que, desde Aristóteles, la lógica había sido “incapaz de dar un sólo paso adelante, por lo que, en apariencia, estaba acaba y completa“.

La observación central de Aristóteles era que los argumentos eran válidos o no en base a su estructura lógica, independientemente de las palabras no – lógicas que pudiesen incluir. El esquema más famoso que discutió fue el silogismo:

⦁ Todos los hombres son mortales.

⦁ Sócrates es un hombre.

⦁ Entonces, Sócrates es mortal.

Puedes reemplazar “Sócrates” con cualquier otro sujeto, y “mortal” con cualquier otro predicado y el argumento continúa siendo válido. La validez del argumento viene determinada solamente por la estructura lógica. Las palabras lógicas: ‘todo’, ‘es’, ‘son’ y ‘entonces’; hacen todo el trabajo.

Aristóteles también definió un conjunto de axiomas básicos que derivaron en el resto de su sistema lógico:

⦁ Un objeto es lo que es (Ley de la Identidad)

⦁ Ninguna afirmación puede ser cierta y falsa a la vez (Ley de la No Contradicción)

⦁ Cada afirmación es o cierta o falsa (Ley de la Exclusión)

Estos axiomas no intentaban describir cómo piensa la gente (eso es del reino de la psicología) pero sí como debería pensar una persona ideal y perfectamente racional.

El método axiomático de Aristóteles influenció un libro aún más famoso, “Los Elementos” de Euclides, del que se estima que es el segundo (siguiendo a la Biblia) en ediciones impresas.

Un Fragmento de Los Elementos de Euclides

Ostentiblemente sobre geometría, Los Elementos se convirtió en un libro de texto estándar para la enseñanza del razonamiento deductivo riguroso. (Abraham Lincoln dijo una vez que aprendió a argumentar legalmente estudiando a Euclides). El el sistema euclídeo, las ideas geométricas se representaban como diagramas espaciales.

Edición de Oliver Byrnes de 1847 de los Elementos de Euclides.

La práctica de la geometría continuó siendo así hasta René Descartes, en los 1630s, cuando demostró que la geometría se podía expresar mediante fórmulas. Su Discurso del Método fue el primer texto matemático de occidente que popularizó lo que ahora denominamos como notación algebraica: “x, y, z para variables; a, b, c para valores conocidos, etc..”

El álgebra de Descartes permitió a los matemáticos ir más allá de las intuiciones espaciales para manipular símbolos usando reglas de fórmulas definidas de un modo muy preciso. Esto cambió el modo dominante de las matemáticas; de los diagramas a las fórmulas, conduciendo, entre otras cosas, el desarrollo del cálculo, inventado más o menos 30 años antes de Descartes por Isaac Newton y Gottfried Leibniz.

La meta de Boole en respecto a la lógica Aristotélica era lo que Descartes había hecho para la geometría Euclídea: liberarla de los límites de la intuición humana dándole un notación algebraica precisa. Para poner un ejemplo simple, cuando Aristóteles escribió:

⦁ Todos los hombres son mortales

Boole reemplazó ‘hombres’ y ‘mortales’ con variables y las palabras logicas ‘todos’ y ‘son’ con operadores aritméticos:

⦁ x = x * y

Lo que se puede interpretar como: “Todo lo que hay en el conjunto x también está en el conjunto y”

Las Leyes del Pensamiento crearon un nuevo campo de educación (la lógica matemática) que en los años venideros se convertiría en una de las áreas de investigación más activas para matemátic@s y filósof@s. Bertrand Russell describió a Las Leyes del Pensamiento como “el trabajo en que se descubrieron las matemáticas puras“

La visión de Shannon fue que el sistema de Boole se podía mapear directamente en los circuitos eléctricos. En esos tiempos, los circuitos eléctricos no tenían ninguna teoría sistemática que gobernase su diseño. Shannon se dio cuenta que la teoría correcta seria “exactamente análoga al cálculo de proposiciones usado en el estudio simbólico de la lógica“. Demostró la correspondencia entre los circuitos eléctricos y los operadores Booleanos en un simple gráfico

Esta correspondencia permitió a l@s Ingenier@s Informátic@s importar décadas de trabajo en lógica y matemáticas y sus subsiguientes lógicos. En la segunda parte de su paper, Shannon demostró cómo la lógica Booleana se podía usar para un circuito que sumase dos dígitos binarios:

El ‘Sumador’ de Shannon

Poniendo en serie estos circuitos, se podían construir operaciones aritméticas complejas. Fueron los bloques básicos de lo que ahora conocemos como Unidades Aritméticas Lógicas (ALUs), un componente clave de las computadoras modernas y de los procesadores.

ALU

Otro modo de caracterizar el logro de Shannon es que fue el primero en distinguir entre la capa lógica y la capa física de los ordenadores. Esta distinción es tan fundamental en la informática que puede parecer sorprendente a los lectores modernos cómo de innovadora fue en su momento. Un recordatorio a la máxima: “la filosofía de un siglo es el sentido común del siguiente”

Desde la aparición del paper de Shannon, un gran número de progresos se ha hecho en la capa física de los ordenadores, incluyendo la invención del transistor en 1947, por William Shockley y sus colegas en Bell Labs. Los transistores son versiones hormonadas de los relés de Shannon (el mejor modo de codificar las operaciones Booleanas).

El Transistor de 1947

En los siguientes 70 años, la industria de los semiconductores fue reduciendo los transistores a piezas cada vez. más pequeñas. Para hacernos un poco a la idea, un iPhone de 2016 tiene unos 3.3 Billones de transistores, cada uno de ellos, cambia igual que los diagramas de Shannon.

Mientras que Shannon demostraba cómo mapear la lógica en el mundo físico, Turing demostró como diseñar ordenadores en el lenguaje de la lógica matemática. Cuando en 1936, Turing escribió en su paper, estaba intentando solucionar “el problema de decisión” identificado en primer término por el matemático David Hilbert, quien preguntó si podía haber un algoritmo que fuese capaz de determinar si una afirmación matemática arbitraria era cierta o falsa.

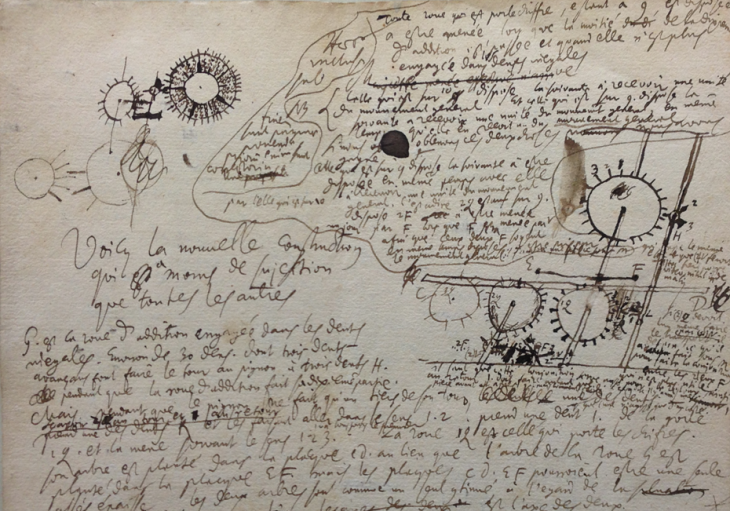

En contraste con el paper de Shannon, el de Turing era muy técnico. Su relevancia histórica no reside en su respuesta al problema de decisión, sino en la plantilla para el diseño de los ordenadores. Turing trabajaba a la usanza de Leibniz, el gigante filosófico que desarrolló el cálculo en paralelo y a la vez que Newton, sin conocerse entre ellos. Entre todas las grandes contribuciones de Leibniz al pensamiento moderno, una de las más intrigantes era la idea de un nuevo lenguaje llamado la “característica universal“, que imaginaba, podía representar todo el conocimiento matemático y científico. Inspirado por el filósofo religioso del siglo XIII, Ramon Llull, Leibniz postuló que el lenguaje podría ser ideográfico cómo los jeroglíficos Egipicios, excepto algunos caracteres que podrían corresponder a conceptos “atómicos” de las matemáticas y de las ciencias. Argumentó que este lenguaje podía ofrecer a la humanidad un instrumento que podría incrementar la razón humana “más allá de los instrumento ópticos” cómo el microscopio y el telescopio.

Ramon Llull

Leibniz también imaginó una máquina que podía procesar el lenguaje:

“Si tienen que aflorar controversias, no habrá ya más disputas entre dos filósofos que las que hay entre dos contables. Será suficiente con que cada uno coja su lápiz y diga: Calculemos“. Leibniz no tuvo la oportunidad de desarrollar su lenguaje universal o su máquina (aunque sí que inventó una calculadora simple, la máquina de Leibniz o Stepped Recknoner).

Stepped Recknoner

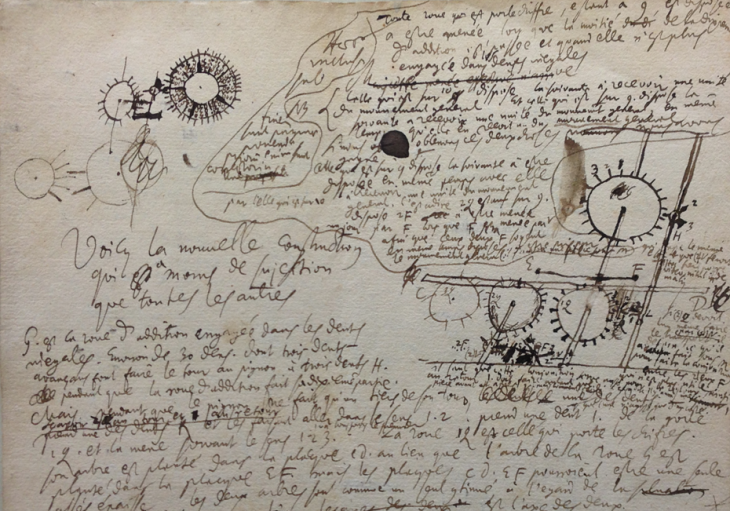

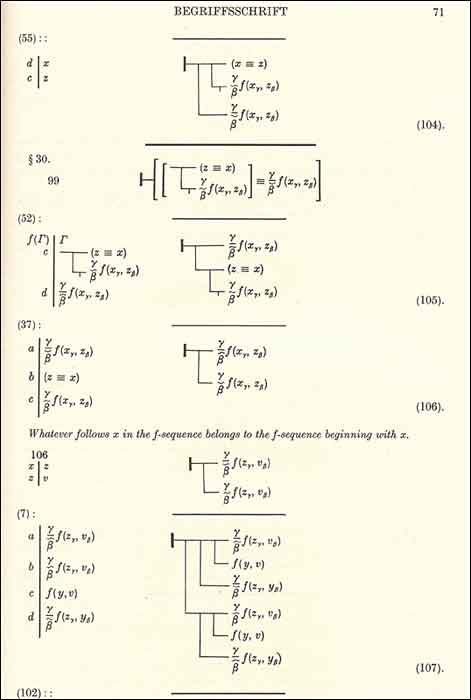

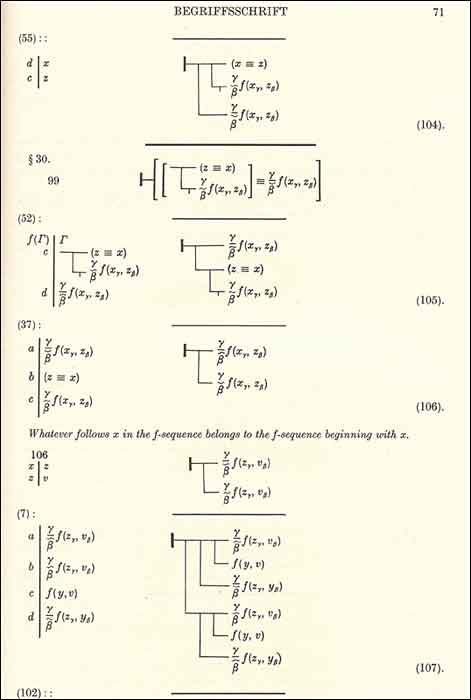

El primer intento creíble de hacer una realidad el sueño de Leibniz fue en 1879, cuando el filósofo alemán Gottlob Frege; publicó su tratado lógico Begriffsschrift. Inspirado por el intento de Boole de mejorar la lógica Aristotélica, Frege desarrolló un sistema lógico mucho más avanzado. La lógica que se enseña hoy en día en las clases de filosofía y de informática (lógica de primer orden o lógica de predicado) es tan sólo una pequeña modificación del sistema de Frege.

Se considera a Frege como uno de los filósofos más importantes del siglo XIX. Entre otras cosas, se le atribuye la catalización de lo que Richard Rorty (filósofo) llamó “el cambio lingüístico” en filosofía. La filosofía estaba obsesionada sobre las cuestiones del conocimiento, la filosofía después de Frege se obsesionó con cuestiones del lenguaje. Sus discípulos incluían a dos de los filósofos más importantes del siglo XX: Bertrand Russell y Ludwig Wittgenstein.

La mayor innovación de la lógica de Frege es que se representa de modo más preciso con la estructura del lenguaje ordinario. Entre otras cosas, Frege fue el primero en usar cuantificadores (“para todo”, “existe”) y a separar los sujetos de los predicados. También fue el primero en desarrollar lo que hoy son conceptos fundamentales de la informática como las funciones recursivas y las variables con ámbito. El lenguaje formal de Frege (lo que él llamo su “concept-script”) está hecho de símbolos sin significados que se manipulan mediante reglas bien definidas. El lenguaje tan sólo tiene significado mediante la interpretación, que se especifica de un modo separado (esta distinción acabaría siendo sintaxis contra semántica). Esto convirtió a la lógica en lo que los eminentes informáticos Allan Newell y Herbert Simon han llamado “el juego del símbolo”, “jugado con trozos sin significado de acuerdo con reglas puramente sintácticas”.

Frege

Como Bertrand Russell dijo: “Las matemáticas se definirían como la materia en que nunca sabemos de lo que estamos hablando, o si lo que decimos es cierto“.Una consecuencia inesperada del trabajo de Frege fue el descubrimiento de las debilidades de los fundamentos de las matemáticas. Por ejemplo, Los Elementos de Euclides (considerado el patrón oro del rigor lógico durante miles de años) demostró estar plagado de errores lógicos. Dado que Eúclides utilizaba palabras ordinarias como ‘línea’ y ‘punto’; él (y siglos de lectores) se engañaron a sí mismos haciendo asunciones sobre frases que contenían esas palabras. Para dar un ejemplo fácil, en su uso ordinario, la palabra ‘línea’ implica que dados tres puntos que pertenecen a una línea, uno de los 3, DEBE estar necesariamente entre los otros dos. Pero cuando definimos ‘línea’ mediante lógica formal, nos damos cuenta que ‘el estar en el medio’ también debe ser definido; una cosa que Euclides obvió. La lógica formal hace que huecos así sean fáciles de ver.

Esta noticia creó una crisis en el fundamento de las matemáticas. Si Los Elemetos (la Biblia de las matemáticas) contenía errores lógicos, ¿Qué otros campos de las matemáticas también presentaban errores? ¿Qué pasaba con aquellas ciencias construidas sobre las matemáticas, cómo la física? Las buenas noticias fueron que los mismos métodos que se usaron para descubrir estos errores, fueron los que se usaron para corregirlos. Los matemáticos empezaron a reconstruir los fundamentos de las matemáticas de abajo a arriba.

En 1889, Giuseppe Peano desarrolló axiomas para la aritmética y, en 1899, David Hilbert hizo lo propio con la geometría. Hilbert también destacó un programa para formalizar el resto de las matemáticas, con requerimientos específicos que siempre deberían verse satisfechos:

⦁ Complitud: debe haber una prueba que todas las afirmaciones matemáticas ciertas se puedan demostrar mediante el sistema formal.

⦁ Decidibilidad: Tiene que existir un algoritmo para decidir la certeza o falsedad de cualquier afirmación matemática. Este es el problema de decisión o Entscheidungsproblem referenciado en el trabajo de Turing.

David Hilbert

David Hilbert

Reconstruir las matemáticas de modo que satisfacieran estos requerimientos se conoció como el programa de Hilbert. Hasta los 1930s fue el foco de un grupo de lógicos que incluía al mismo Hilbert, Russell, Kurt Gödel, John Von Neumann, Alonzo Church y, por supuesto a Alan Turing.

El programa de Hilbert atacaba 2 frentes.

En el primero, los lógicos creaban sistemas lógicos que intentaban demostrar si los requerimientos de Hilbert eran satisfacibles o no.

En el segundo frente, los matemáticos utilizaban los conceptos lógicos para reconstruir las matemáticas clásicas. Por ejemplo, el sistema de Peano para la aritmética empieza con una función simple llamada la función sucesor que incrementa el número dado en uno. Utiliza la función sucesor de modo recursivo para definir la suma, utiliza la suma recursivamente para definir la multiplicación, y sigue, hasta que todas las operaciones de la teoría de números se ha definido. Luego usa estas definiciones, con la lógica formal, para demostrar teoremas sobre la aritmética.

La Música de Los Axiomas de Peano

El historiador Thomas Kuhn observó que “en ciencia, la novedad tan sólo emerge con la dificultad“. La lógica en la era del programa de Hilbert era un proceso tumultuoso de creación y de destrucción. Un lógico podía construir y elaborar un sistema y otro echarlo al suelo. El arma predilecta de destrucción era la construcción de autoreferencias, afirmaciones paradójicas que demostraban que los axiomas de los que se derivaban eran inconsistentes. Una forma simple de “la paradoja del mentiroso” es la frase: Esta Frase Es Falsa. Si es cierta entonces es falsa y, si es falsa entonces es cierta; conduciéndonos así a un torbellino infinito de auto contradicción.

Russell hizo el primer uso notable de la paradoja del mentiroso en la lógica matemática. Demostró que el sistema de Frege permitía derivar conjuntos que se auto contradecían:

“Sea R el conjunto de conjuntos que no son miembros de sí mismos. Si R no es miembro de sí mismo, entonces su definición indica que debe contenerse a sí mismo, y si R se contiene a sí mismo entonces contradice su propia definición cómo conjunto de todos los conjuntos que no pertenecen a sí mismos“

Esto se convirtió en la paradoja de Russell y fue un serio golpe en los logros de Frege. Frege, en shock por este descubrimiento contestó a Russell: “Su descubrimiento de la contradicción me ha causado una gran sorpresa y, casi diría, consternación ya que ha hecho temblar la base sobre la que intentaba construir mi aritmética“

Russell y su colega Alfred North Whitehead pusieron el intento más abicioso de completar el programa de Hilbert con la publicación en 3 volúmenes de Principia Matemática entre 1910 y 1913. El método de Principia era tan detallado que necesitó de más de 300 páginas para demostrar que 1+1=2. Russell y Whitehead intentaron resolver la paradoja de Frege introduciendo lo que llamaron la teoría de tipos. La idea residía en partir los lenguajes lógicos en múltiples niveles o tipos. Cada nivel podía hacer referencia a los niveles inferiores, pero no a los niveles superiores. Esto resolvía paradojas auto referenciales, prohibiendo la auto referencia. No fue una solución muy popular entre los lógicos, pero influenció a la informática, la mayoría de los lenguajes modernos tienen características inspiradas por la teoría de tipos.

La primera explosión fue en 1931, cuando Gödel publicó su, ahora famoso, teorema de la incomplitud, que demostraba que cualquier sistema lógico consistente lo suficientemente poderoso para acompañar a la aritmética debía contener afirmaciones que son ciertas pero que no puede demostrarse que lo son.

El último toque apareció cuando Turing y Alonzo Church probaron independientemente que no podía existir algoritmo alguno que fuese capaz de determinar si una afirmación era cierta o falsa. Church lo hizo inventando un sistema totalmente independiente llamado cálculo lambda, que más tarde inspiró lenguajes de programación como LISP. La respuesta al problema de la decisión era negativa.

La visión clave de Turing apareció en la primera sección de su famoso paper de 1936: “On Computable Numbers, With an Application to the Entscheidungsproblem“. Para poder formular de modo riguroso el problema de decisión (Entscheidungsproblem), Turing creó un modelo matemático de lo que significa ser un ordenador (hoy en día, las máquinas que encajan en este modelo se les llama “máquinas universales de Turing“).

Máquina Universal de Turing

Como lo describe el lógico Martin Davis: “Turing sabía que un algoritmo se describe típicamente por una lista de reglas que una persona puede seguir de modo preciso y mecánico, como una receta de libro de cocina. Era capaz de demostrar que esa persona podía estar limitada a unas pocas y extremadamente básicas acciones sin cambiar el resultado final de la computación. […] Luego, demostrando que ninguna máquina que llevase a cabo tan sólo esas acciones básicas podía determinar si o no, una conclusión que sigue las premisas de Frege, fue capaz de concluir que no existía algoritmo alguno para el problema de la decisión. […] Como subproducto, encontró un modelo matemático para una máquina de computación multiuso“

Lo siguiente que hizo Turing fue demostrar cómo un programa podía almacenarse dentro de un ordenador junto con los datos con los que opera. En el vocabulario de hoy en día, diríamos que inventó la arquitectura de los programas almacenados que residen bajo la mayoría de los ordenadores modernos:

“Antes de Turing, la suposición general era que el lidiar con esas máquinas de 3 categorías (máquina, programa y datos) pasaba por separarlas enteramente en 3 entidades. La máquina era el objeto físico; hoy es el hardware. El programa era el plan para llevar a cabo una computación, ya sean tarjetas perforadas o cables en enchufes. Finalmente los datos eran inputs numéricos. La máquina universal de Turing demostró que la distinción de esas 3 identidades era pura ilusión“

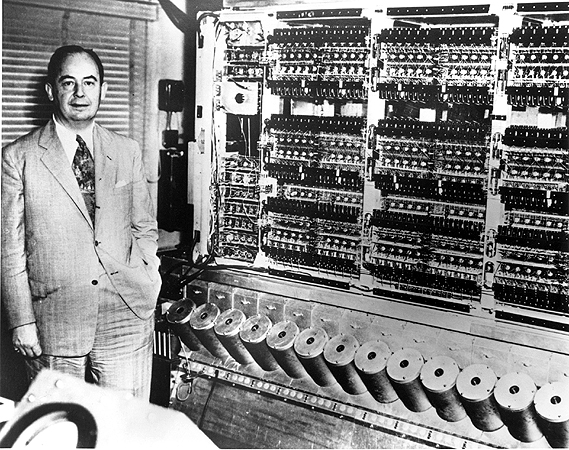

Fue la primera demostración rigurosa que cualquier lógica computacional que pudiese ser codificada en hardware también se podía codificar en software. La arquitectura que describió Turing, más tarde se llamó “La Arquitectura de Von Neumann“; aunque muchos historiadores modernos están de acuerdo con que era de Turing, del mismo modo que lo reconoció el mismo Von Neumann.

Aunque, a un nivel técnico, el programa de Hilbert fue un fallo, los esfuerzos que se hicieron durante su desarrollo demostraron que grandes porciones de las matemáticas podían construirse a partir de la lógica. Y después de las visiones de Shannon y Turing (demostrando las conexiones entre la electrónica, la lógica y la computación) fue posible exportar esa nueva maquinaria conceptual al diseño de ordenadores. Durante la Segunda Guerra Mundial, todo este trabajo teórico se puso en práctica, cuando los laboratorios de los gobiernos reclutaron un gran número de lógicos de élite.

Von Neumann se unió al proyecto de la bomba atómica en Los Alamos, donde trabajó en el diseño de ordenadores dando soporte a la investigación de l@s físic@s. En 1945 escribió la especificación del EDVAC -Electronic Discrete Variable Automatic Computer- (el primer programa almacenado y basado en lógica), lo que se considera el origen definitivo de la guía para el desarrollo del diseño de ordenadores.

Turing se unió a una unidad secreta en Betchey Park, al noroeste de Londres, donde ayudó a diseñar computadoras especializadas en romper los códigos Alemanes. Su mayor contribución al diseño práctico de ordenadores fue la especificación del ACE (Automatic Computing Engine)

Turing y ACE

Al ser las primeras computadoras basadas en lógica booleana y en arquitecturas de programas almacenados, el ACE y el EDVAC eran similares de muchos sentidos. Pero también presentaban diferencias interesantes, algunas de las cuales han avivado muchos de los debates modernos en el diseño de computadores.

Von Neuman pensaba que la programación de las computadoras sería un trabajo tedioso, clerical. Turing, en contraste, afirmó que la programación de ordenadores “Sería muy fascinante. No hay peligro alguno de convertirse en esclavos para muchos procesos que son mecánicos y que los puede hacer una máquina“.

Desde los años 1940s, la programación de ordenadores se ha ido sofisticando más y más. Una cosa que no ha cambiado es que aún es, básicamente (con algunas excepciones) que l@s programdor@s especifiquen las reglas que los ordenadores deben seguir. En términos filosóficos, diríamos que la programación de ordenadores ha seguido la tradición de la lógica deductiva, la rama de la lógica que hemos aprendido en este Brain Feeling, que lidia con la manipulación de los símbolos siguiendo reglas formales.

En la última década, la programación ha empezado a cambiar con la creciente popularidad del machine learning, que incluye la creación de entornos de trabajo donde las máquinas puedan aprender a partir de inferencia estadística. Esto ha llevado a la programación más cerca de otra de las ramas de la lógica, la lógica inductiva, que lidia con reglas de inferencia de instancias específicas.

Hoy en día la técnica más prometedora de machine learning es el uso de redes neuronales, se se inventaron en los 1940s por Warren McCulloch y Walter Pitts, cuya idea era desarrollar un cálculo para las neuronas que pudiese, cómo la lógica Booleana, ser usado para la construcción de circuitos de ordenadores. Las redes neuronales permanecieron esotéricas hasta que décadas después se combinaron con técnicas estadísticas, que les permitió mejorar a medida que se les alimentaba con más datos.

Recientemente, dado que los ordenadores tienen grande aceptación y sostienen conjuntos de datos cada vez más grandes, estas técnicas han demostrado unos resultados recalcables.

La programación en el futuro será como exponer las redes neuronales al mundo y dejar que aprendan. Esto será en segundo acto de la historia de los ordenadores.

La lógica empezó como un modo de entender las leyes del pensamiento. Luego ayudó a crear máquinas que podían razonar de acuerdo con las reglas de la lógica deductiva. Hoy, la lógica deductiva e inductiva se combinan para crear máquinas que razonen y aprendan. Lo que empezó, en palabras de Boole, con una investigación “consistente en la naturaleza y la constitución de la mente humana“ puede resultar en la creación de nuevas mentes (mentes artificiales) que algún día podrán ser como las nuestras o incluso superarlas.

Buen Domingo!!

Artículo Original: “How Aristotle Created the Computer” en The Atlantic

https://feelthebrain.me/tag/leibniz/

Comentarios (26)

Yo trabajo de forma distal y mi espacio de trabajo es el tercer entorno. Pero siempre he estado en un lugar agradable en la que los ciberciudadanos cooperan, colaboran y sin tener moradas que hipotecan de por vida.

Pero por desgracia uso servicios de esos señores del aire, no tengo más remedio. El mundo actual nos obliga a consumir espacios digitales privados y reconozco que hago más ricos a los que ya lo eran. Ojalá en unos años haya una propiedad pública de los servicios esenciales de la ciberciudadanía.

Una idea en positivo para seguir dinamizando el debate. Siendo posibilistas y tomando como referencia el contexto dinámico en el que se producen las innovaciones —que obliga a una continua revisión de la estrategia—, una línea de trabajo interesante que están aplicando algunos centros y redes de académicos para tratar de “empujar” la actividad de la universidad hacia el cumplimiento de sus fines sería la de la apertura de contenidos, prácticas y tecnologías (ver, www.ubiquitypress.com/site/books/detail/11/battle-for-open/) Parece que los enfoques abiertos aplicados a la actividad de la universidad podrían ayudar a reducir la excesiva dependencia actual y (previsiblemente) futura de los “Señores del Aire” que denuncia Javier en su artículo.

En este mundo tecnológico en el que "lo último" secuestra casi siempre nuestra atención y consigue esquivar nuestra capacidad de reflexión sosegada, es magnífico encontrar aportaciones como esta que nos ayudan a generar procesos deliberativos. Gracias.

Como investigadores y docentes podemos hacer consciencia entre nuestros compañeros y alumnos sobre la pertinencia de usar estos servicios, creo que podemos usarlos pero no depender de ellos, debemos tener siempre nuestros respaldos en dispositivos propios o de nuestras universidades. También es preocupante el nivel de privacidad que ofrecen las empresas a nuestra información, pues bien podrían tener más información de nosotros que nosotros mismos y ante esta situación ¿cómo se nos garantiza el buen uso de esos datos?

A este respecto, no hay que olvidar que el consumo es uno de los factores decisivos con el que los poderes económicos financieros, los señores del aire real en que vivimos, quieren por este mecanismo sacralizar al dinero como único valor y así clonarnos socialmente.

Tu llamada de atención y tus propuestas y sugerencias son muy bienvenidas. .

Redefinir la universidad es una tarea a las que todas las instituciones de Educación Superior se enfrentan, en esta primera mitad del siglo XXI. Y por ello escapa a las posibilidades de este texto que ha decidido centrarse en un único aspecto: la universidad integrándose en la red del conocimiento, en un mundo dividido por la red.

Las diferentes reflexiones que integran este tema provienen de investigadores de diferentes países europeos y latinoamericanos y su interés proviene tanto de la calidad de las aportaciones como de su diversidad de puntos de vista.

Pero poco a poco vemos como el conocimiento se escapa de sus aulas y se filtra por la red, muchas organizaciones han comenzado a implementar estas nuevas tecnologías para reducir más los costos a través de una utilización mejorada delas máquinas y de una reducción del tiempo administrativo y de los costos de infraestructura. La computación en nube es el entorno que permite a los clientes utilizar aplicaciones en Internet, por ejemplo, almacenamiento y protección de datos, mientras que se brinda un servicio.

Es cierto que solo un puñado de grandes compañías dominan estos espacios, y que realmente nada es tan bueno a pesar de su alarde de gratuidad, el conocimiento de las necesidades de cada una de las personas conectadas a estas redes significa nuevos mercados, conocimiento de tendencias, no por el hecho de mostrar todo desde la cara amable del asunto significa que lo sea, por el contrario, se crea un debate entre cuánto de ese gran pastel es de mi pertenencia y cuánto es en verdad la cantidad que se ha depositado en dichos instrumentos.

Las universidades antes de dejarse llevar, deben aunar en la investigación y el compromiso serio y consensuado de lo que puede ofrecer a sus educandos a través de la ramificación e incursión en la nube, lo privado siempre seguirá siendo privado por más que se venda de otra forma, la verdadera importancia está en conectar espacios educativos entre universidades, bases de datos de conocimiento que permitan la exploración y la creatividad de cada uno de los que se encuentren involucrados.

Los avances de la tecnología no son nocivos, solo hacen cambiar la percepción de lo que se conoce y la constante evolución del entorno, es el uso que se le da a cada una de estos nuevas herramientas depende única y exclusivamente del utilitario, las bondades o incertidumbres que se generen hacen parte de la formación, la dimensión y el alcance hacen parte del objetivo, un objetivo formado por comunidades que desean fomentar conocimiento libre, sea en la nube o en su propio pensar.

Cabe resaltar las reflexiones expuestas por Sugata Mitra ganador del Premio TED 2013, que otorga la organización del mismo nombre, dedicada a presentar conferencias sobre tecnología, educación y diseño. Que se utilizan constantemente los recursos que ofrece la tecnología para llevar a cabo las tareas diarias asignadas en los centros de trabajo, para realizar investigaciones de índole académico, cubrir las necesidades informativas y buscar conexión con el resto planeta.

Universidades en la nube es un concepto mucho más difícil de aceptar. El hecho es que una de las cosas que asumían las profesores de las universidades en sus inicios era que no había que depositar mucha información en la nube, con la esperanza de que, un día, estas llegaran a necesitar algo de todo eso; cuando esto ocurriera, solo había que extraer los datos, razón por la que existen los test para la memoria. Esta creencia ya no es válida, porque en el mundo en que vivimos, si estamos en medio de un problema y necesitamos encontrar algo, lo hacemos de manera inmediata, sin buscarlo dentro de la cabeza.

Un claro ejemplo seria si le pregunto si sabe balancear una ecuación química y usted me dice que no, pero la respuesta a esa pregunta es realmente importante para su vida usted me diría: “Deme media hora y un teléfono inteligente para encontrarla en la nube”. Lo que usted me estaría diciendo es que no necesita saber, pero puede hacerlo cuando lo necesite.

no nos podemos resistir a los cambios es algo que es inevitable, lo que no se puede permitir es que los cambios sean utilizados para manipulación y control de las personas generando así mas desigualdad en la humanidad

Esto lo único que refleja es la falta de interés que tienen los gobiernos latinoamericanos en sus estudiantes y en el conocimiento generado por los mismo.

¿Es realmente justo que esto suceda?

lo malo de la situación es que solo unas pocas empresas son las encargadas de manejar estos espacios y se están enriqueciendo con estos situacion, estos espacios debieran ser subsidiados por los gobiernos en especial el Internet, que en el momento es costoso si quiere una buena velocidad, y asi tener igualdad para poder competir en este medio tecnológico.